Automated speech markers of Alzheimer’s dementia: Test of cross-linguistic generalizability

Pérez-Toro, P. A., Ferrante, F., Pérez, G., Tee, B. L., de Leon, J., Nöth, E., Schuster, M., Maier, A., Slachevsky, A., Gorno-Tempini, M. L., Ibáñez, A., Orozco-Arroyave, J. R. & García, A. M. (2025). Automated speech markers of Alzheimer’s dementia: Test of cross-linguistic generalizability. Journal of Medical Internet Research 27, e74200.

Antecedentes: El análisis automatizado del habla y el lenguaje (AAHL) está ganando impulso como un enfoque no invasivo, asequible y escalable para la detección temprana de la enfermedad de Alzheimer (EA). Sin embargo, la literatura presenta dos limitaciones notables. En primer lugar, muchos estudios utilizan características derivadas computacionalmente que carecen de interpretabilidad clínica. En segundo lugar, una proporción significativa de los estudios de AAHL se han realizado exclusivamente en hablantes de inglés. Estas deficiencias reducen la utilidad y la generalización de los hallazgos existentes.

Objetivo: Para abordar estas deficiencias, investigamos si las características lingüísticas interpretables pueden identificar de manera confiable la EA tanto dentro como fuera de las fronteras lingüísticas, centrándonos en pacientes de habla inglesa y española y controles sanos (CS).

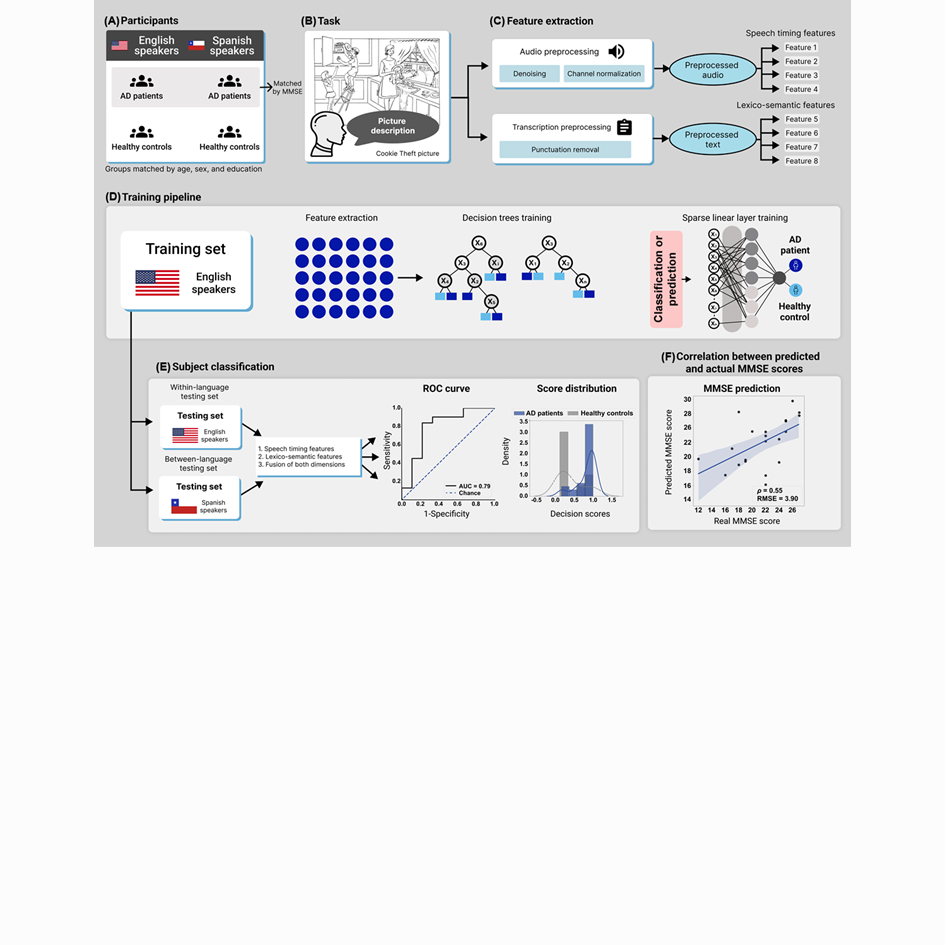

Métodología: Analizamos grabaciones de voz de 211 participantes, entre los que se encontraban 117 angloparlantes (58 pacientes con EA y 59 controles sanos) y 94 hispanohablantes (47 pacientes con EA y 47 controles sanos). Los participantes completaron una tarea validada de descripción de imágenes del Examen Diagnóstico de Afasia de Boston, que provocaba un habla natural en condiciones controladas. Las grabaciones se preprocesaron y transcribieron antes de extraer (1) las características temporales del habla (por ejemplo, la duración de las pausas, las proporciones de los segmentos del habla y la velocidad de la voz) y (2) las características léxico-semánticas (proporciones de categorías léxicas, granularidad semántica y variabilidad semántica). Los clasificadores de aprendizaje automático se entrenaron con datos de pacientes y controles sanos angloparlantes, y luego se probaron (1) en un entorno intralingüístico (con pacientes y controles sanos angloparlantes) y (2) en un entorno interlingüístico (con pacientes y controles sanos hispanohablantes). Además, las características se utilizaron para predecir el funcionamiento cognitivo medido por el Mini-Mental State Examination (MMSE).

Resultados: En la condición dentro del mismo idioma, la combinación de las características de sincronización del habla y léxico-semánticas produjo una clasificación máxima (área bajo la curva característica operativa del receptor [AUC]=0,88), superando a los modelos de una sola característica (AUC=0,79 para las características de sincronización; AUC=0,80 para las características léxico-semánticas). Las características temporales mostraron la predicción MMSE más sólida (R = 0,43, P < 0,001). En la condición entre idiomas, las características temporales del habla se generalizaron bien a los hispanohablantes (AUC = 0,75) y predijeron las puntuaciones MMSE de los pacientes hispanohablantes (R = 0,39, P < 0,001). Las características léxico-semánticas mostraron un rendimiento inferior (AUC = 0,64) y no predijeron de forma significativa el MMSE (R = –0,31, P = 0,05). El modelo combinado no mejoró los resultados (AUC = 0,65; R = 0,04, P = 0,79).

Conclusiones: Estos resultados sugieren que, si bien tanto las características temporales como las léxico-semánticas son informativas dentro de un mismo idioma, solo las características temporales del habla muestran un rendimiento constante en todos los idiomas. Al centrarse en características clínicamente interpretables, este enfoque respalda el desarrollo de herramientas AAHL clínicamente utilizables.

Para acceder al artículo, hacé click aquí.

Automated speech markers of Alzheimer’s dementia: Test of cross-linguistic generalizability

Pérez-Toro, P. A., Ferrante, F., Pérez, G., Tee, B. L., de Leon, J., Nöth, E., Schuster, M., Maier, A., Slachevsky, A., Gorno-Tempini, M. L., Ibáñez, A., Orozco-Arroyave, J. R. & García, A. M. (2025). Automated speech markers of Alzheimer’s dementia: Test of cross-linguistic generalizability. Journal of Medical Internet Research 27, e74200.

Background: Automated speech and language analysis (ASLA) is gaining momentum as a noninvasive, affordable, and scalable approach for the early detection of Alzheimer disease (AD). Nevertheless, the literature presents 2 notable limitations. First, many studies use computationally derived features that lack clinical interpretability. Second, a significant proportion of ASLA studies have been conducted exclusively in English speakers. These shortcomings reduce the utility and generalizability of existing findings.

Objective: To address these gaps, we investigated whether interpretable linguistic features can reliably identify AD both within and across language boundaries, focusing on English- and Spanish-speaking patients and healthy controls (HCs).

Methods: We analyzed speech recordings from 211 participants, encompassing 117 English speakers (58 patients with AD and 59 HCs) and 94 Spanish speakers (47 patients with AD and 47 HCs). Participants completed a validated picture description task from the Boston Diagnostic Aphasia Examination, eliciting natural speech under controlled conditions. Recordings were preprocessed and transcribed before extracting (1) speech timing features (eg, pause duration, speech segment ratios, and voice rate) and (2) lexico-semantic features (lexical category ratios, semantic granularity, and semantic variability). Machine learning classifiers were trained with data from English-speaking patients and HCs, and then tested (1) in a within-language setting (with English-speaking patients and HCs) and (2) in a between-language setting (with Spanish-speaking patients and HCs). Additionally, the features were used to predict cognitive functioning as measured by the Mini-Mental State Examination (MMSE).

Results: In the within-language condition, combined speech timing and lexico-semantic features yielded maximal classification (area under the receiver operating characteristic curve [AUC]=0.88), outperforming single-feature models (AUC=0.79 for timing features; AUC=0.80 for lexico-semantic features). Timing features showed the strongest MMSE prediction (R=0.43, P<.001). In the between-language condition, speech timing features generalized well to Spanish speakers (AUC=0.75) and predicted Spanish-speaking patients’ MMSE scores (R=0.39, P<.001). Lexico-semantic features showed lower performance (AUC=0.64) and no significant MMSE prediction (R=–0.31, P=.05). The combined model did not improve results (AUC=0.65; R=0.04, P=.79).

Conclusions: These results suggest that while both timing and lexico-semantic features are informative within the same language, only speech timing features demonstrate consistent performance across languages. By focusing on clinically interpretable features, this approach supports the development of clinically usable ASLA tools.

To access the full paper, please click here.